Google 搜寻不断改进,最近就引入并成功应用一个新的运算模型,更能理解搜寻查问内容,从而提供更准确的回应。

由上年开始 Google 试行引进名为 Bidirectional Encoder Representations from Transformers (BERT) 的 NLP pre-training 模型技术。BERT 模型会考虑句子中每一个字跟前后其他字的关联意思,这样对于理解搜寻查询十分有帮助。在一些较长如对话般的搜寻查询,中间会夹杂了介词如 to, for 等,使用了 BERT Model 后就能够更完整准确理解搜寻查询的真实意思。

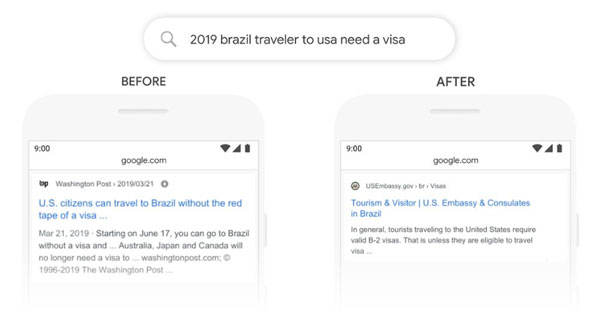

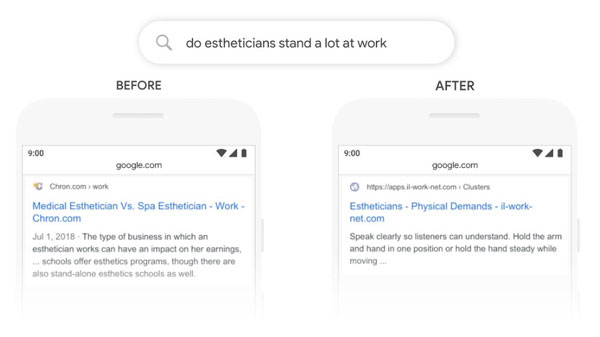

Google 举出了一些例子,展示应用 BERT Model 搜寻结果的不同。

第一个例子 2019 brazil traveler to usa need a visa,过往搜寻时 Google 会忽视了一间 to 字,并因应其他关键字比重而得出美国人前往巴西 Visa 相关的资讯,在 BERT Model 就能正确理解查询内容应为巴西人前往美国。

另一个例子,”for someone” 是查询中重要的一部份。未应用 BERT Model 搜寻会忽视了 “for someone”,现在就能够知道 “for someone” 在句子中的作用。

虽然 BERT Model 是软件运算上的改进,但亦需要硬件上配合才可。由于 BERT 运算更复杂,原本应用的硬件配置亦到达极限,所以 Google 亦应用 Cloud TPUs 去用于提供搜寻结果,以便用家可以更快获得所需资讯。

BERT model 最初是用于英文上,在成功应用后 Google 已将 BERT 应用于其他语言,包括韩文, 印度语, 葡萄牙语等,并会陆续扩展至其他语言。

Source: Google Blog